EPRパラドックス

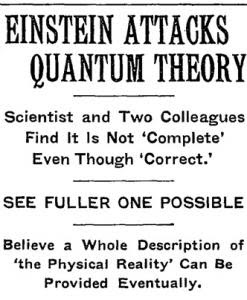

「神はサイコロを振らない」 アインシュタインが、量子論に懐疑的だったことは、よく知られていると思う。もっとも、彼がこうしたアプリオリな哲学的立場から量子論を批判したと思うのは、正しくないと思う。今日紹介する論文でも、彼は、明確に次のように述べている。 「物理的実在の基本原理を、アプリオリな哲学的思索によっては決定することはできない。それは、実験と観測の結果に訴えることで見出されなければならない。」 "Can Quantum-Mechanical Description of Physical Reality Be Considered Complete ?" 「物理的な実在の量子力学の記述は、完全なものと考えることができるか?」 https://goo.gl/qAWacP 量子論の否定は、現在の我々の目から見れば、明らかに、アインシュタインの「誤り」と言っていいものだが、彼が量子論の中に見つけた「矛盾」は、当時の物理学者の誰も気がつかなかった深いものだった。 1935年に、アインシュタインとポドルスキーとローゼンは、概略、次のような思考実験を論文として発表する。(前述の論文。三人の著者の頭文字をとって、EPR論文と呼ばれることがある。) ある系 I と、ある系 II とが、時刻 t=0 から t=T の間に相互作用するとする。ただし、t > T 以降は、二つの系には相互作用がないとする。量子力学に従えば、シュレディンガーの波動方程式 Ψ で、結合された系 I + II の状態を、全ての時間に渡って計算できることになる。単純な例として、二つの系を二つの粒子 x1とx2 だと考えてみよう。その時、Ψ(x1 , x2) で、二つの粒子からなる系の状態を計算できる。 今、系 I の粒子 x1の運動量を観測して運動量 p を得たとする。量子力学によれば、粒子の粒子の運動量の値は、観測によって粒子の状態を記述する波動方程式が収縮することによって初めて確定する。ところが、この収縮したΨをよく見ると、系 II の粒子x2の運動量が -pで与えられることが、計算でわかる。実際に系 II で、粒子 x2 の運動量を観測しても、計算どうりに、-p を得るだろう。 同様に、系 I の粒子 x1の位置を観測して位置 q を得