アルゴリズム論的熱力学

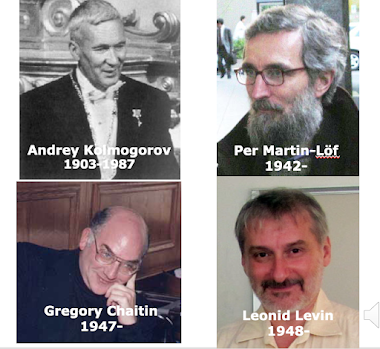

【 アルゴリズム論的熱力学 】 https://youtu.be/n2O8H0UDhqE?list=PLQIrJ0f9gMcOWKDmKxI3aJ6UYf6gaPa2K ここでは、John BaezとMike Stayの 2013年の論文 “Algorithmic Thermodynamics” を紹介します。https://arxiv.org/abs/1010.2067 John Baez は、先に見た古典的な熱力学の観測量を、アルゴリズム論的情報理論の観測量で置き換えたモデルを考えました。 E(x)を、プログラムxの実行時間の対数 V(x)を、プログラムxの長さ N(x)を、プログラムxの出力 とします。 この時、ある分配関数を考えて、確率分布 Gibbs Ensemble を構成します。 式については、pdfを参照ください。 https://drive.google.com/file/d/1rZY-ePmL9Ox1gPnkhL1fYFbO3kfjVXKx/view?usp=sharing これらから、観測量 E(x), V(x), N(x) の共役変数 𝛽,𝛾,𝛿を使って、期待値 E,V,Nを定義できます。 注意して欲しいのは、ここでの、E(x), V(x), N(x) の選択は、必然的なものではありません。ある意味、恣意的です。 用語については、まぎらわしいかもしれないですが、古典的な熱力学のGibbs Ensembleの例を流用しています。 重要なことは、、古典的な熱力学と同じ方法で、アルゴリズム論的熱力学が構成可能なことを示せるということです。それが、Gibbs Ensembleの方法の強みです。 また、計算時間、プログラムの長さ、プログラムの出力という観測量は、アルゴリズム論的情報理論にとっては、重要なものです。 さきには、「まぎらわしい」と言いましたが、次のように考えることもできます。 アルゴリズム論的熱力学のE、すなわち、計算時間の対数は、古典的熱力学のガスの内部エネルギーに似ている。 アルゴリズム論的熱力学のV、すなわち、プログラムの長さは、古典的熱力学の容器の体積に似ている。 アルゴリズム論的熱力学のN、すなわち、プログラムの出力は、古典的熱力学の分子の数に似ている。 はたして、こうしたアナロジーは、どこまで有効なものになる