2011年のChatGPT -- RNNの不思議な能力

【 2011年のChatGPT -- RNNの不思議な能力 】

ChatGPTが登場したのは去年 2022年なので、「2011年のChatGPT」というタイトルは変だと思われたかもしれません。

それには少し訳があります。

2011年、当時GoogleにいたIlya Sutskever は、大量のテキストデータをコンピュータに学習させて、コンピュータに、まったく新しい英語の文章を生成させることに成功して、世界を驚かせます。

現在でも、ChatGPTが自然な英語や日本語を出力するのに驚く人は多いと思いますが、それと同じこと、コンピュータが文法的に正しい自然言語を出力することを、はじめて成功させたのが、Ilya Sutskever でした。

2015年に、彼はGoogleからOpenAIに移り、同社の共同設立者かつChief Scientistになります。ChatGPTをつくったOpenAIの技術の中心にいるはIlya Sutskever です。彼は、自然言語を生成するAI技術のパイオニアなのです。

自然言語を生成する能力を機械が持つことを可能にしたのは、RNNという技術なのですが、Ilyaの成功は、RNNの持つ不思議な力を、多くの人に強く印象づけました。

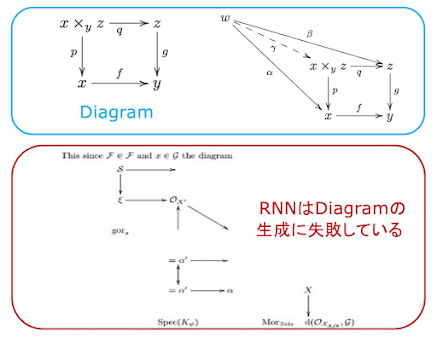

2015年、Andrej Karpathy はRNNを使って驚くべき仕事を行います。彼は、大量の数学の論文をRNNに学習させ、機械に数学の論文を書かせることに成功します。彼は、さらに、Linuxの全ソースコードをRNNに学習させ、Cのコードを機械に書かせることにも成功します。

現在のChatGPTが我々に見せる能力の片鱗は、すでにこの時期に、準備されていたのです。

ただ、残念なことに、Ilyaが生成した文章も、Karpathyが生成した数学の論文もCのプログラムも、大きな問題がありました。それらの出力には、「意味」が欠けているのです。

「意味が欠けている」というのがどう言うことかは、その出力のサンプルをスライドにあげておいたので、スライドのpdfを見て貰えばわかります。

「全然ダメじゃないか」と思われたかもしれません。ただ、こういうところからChatGPTの技術は出発していることは知っておいていいと思います。

大事なことは、RNNには学習したデータから、そのデータの基本的な特徴を「真似る」ことができる能力があることが示されたことです。それは画期的なことだと思います。

例えば、RNNは大量の英文のデータから、英語の基本的な特徴としてその文法を学習して、文法的には正しい英文を吐き出すことが 可能なのです。同様に、RNNは大量のCのソースコードからC言語の構文規則を学習して、正しいCのコードを作り出すことができるのです。

「形から入る」といいますが、何かを「真似る」には、人間でもコンピュータでも、まず「形から入る」のが最初には必要だと言うことなのかもしれません。

2011年のChatGPTは、形を真似ることはできたのですが、意味のあることを語ることができませんでした。

今回のセッションでは、RNNがどんなものかを説明することができませんでした。資料を再掲載したので、ご覧ください。

https://www.marulabo.net/docs/meaning/

コメント

コメントを投稿