Ilya の活躍 -- 「語の意味の固定ベクトル」

【 Ilya の活躍 --「語の意味の固定ベクトル」】

Ilyaの活躍は、続きます。

2014年に、Ilya Sutskever らは、シーケンスをシーケンスに変換するRNN(LSTM)の能力が、機械翻訳に応用できるという論文 "Sequence to Sequence Learning with Neural Networks" を発表します。

「我々の方法では、入力のシーケンスを固定次元のベクトルにマップするのに、多層のLong Short-Term Memory(LSTM)を利用する。その後、別の深いLSTMが、このベクトルから目的のシーケンスをデコードする。」

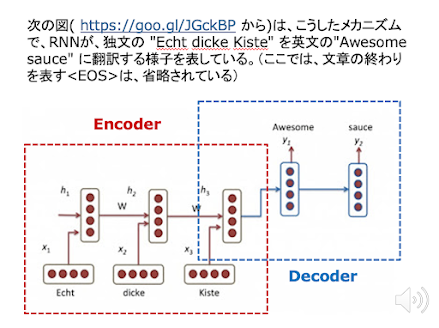

ここでは、先に見た Encoder / Decoder の枠組みが利用されています。入力のシーケンスを固定次元のベクトルにマップするのが Encoder で、この固定次元のベクトルからシーケンスを作るのが Decoder です。

ただ、先に見たHintonのAutoencoder とは少し違うところがあります。Autoencoder は、基本的には 入力と同じものを出力に再現しようとします。Sequence to Sequence では、入力に与えられるSequenceと出力されるSequenceは同じものではありません。例えば、前者のSequenceは英語の文で、後者のSequenceは日本語の文であることがあるように。

それでは、二つのSequence を結びつけているのはなんでしょう。それは二つのSequenceが「同じ意味」を持つということです。前段の入力のSequenceから作られ、後段の出力のSequenceを構成するのに利用される「固定次元のベクトル」とは、二つのSequenceが「同じ意味」を持つことを表現しているSequenceの意味のベクトル表現に他なりません。

ですから、Sequence to Sequenceのシステムは、「語の意味ベクトル」の並びを「文の意味ベクトル」にマップし、その「文の意味ベクトル」から再び「語の意味ベクトル」の並びを生成するシステムです。

-------------------------------

https://www.marulabo.net/docs/meaning/

コメント

コメントを投稿