EntityモデルのFolksonomyとChatGPT

【 EntityモデルのFolksonomyとChatGPT 】

今回のセッションでは、ボイス・アシスタントの意味へのアプローチの紹介しようと考えていました。

ボイス・アシスタントでは、人間の側の発話の意図を機械が把握し、その意図に応えて正しく反応するのが、機械にとっての「意味理解」であるという、意味のPragmatic(「語用論」的)な解釈が取られます。

命令文 ー 命令された動作を行えばいい

疑問文 ー 答えを与えればいい ー>検索を実行

ボイス・アシスタントの代表的な製品である Alexa / Echo では、人間の発話の意図は、Intent という一つの文字列で表現されます。Intentは、基本的には、機械に対する人間からの命令を簡潔に示したものです。こうした単純な意味モデルをIntentモデルと呼びます。

お詫びしですが、前回の最後のスライドで、すこし正確じゃないことを言っていました。Googleの音声検索も、Pragmaticな意味解釈に基づくようなことを言ったのですが、Googleのグラフによる知識表現論は、もっと複雑なものです。

少し補足します。

GoogleのKnowledge Graphは、情報をEntityの構造に対応させる技術です。あるものの「意味」は、対応するEntityが持つ「情報」として解釈されます。Entityは、現実のものであれバーチャルなものであれ、具体的なものであれ抽象的なものであれ、概念としては「実在するもの」とみなされます。ある種の概念実在論と言っていいと思います。

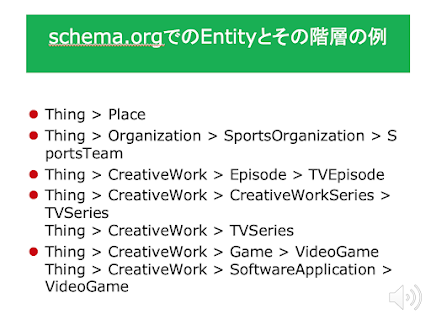

Entityモデルでは、Entityとその関係の構造が表現するものは実在的なものの構造の反映です。こうした関係をEntityの「存在論 "Ontology" 」といいます。少し大袈裟な気もしますが。ですから、Entityを用いれば、具体的な言語表現からは独立な、かつ、全ての言語で共通な情報を与えることが可能です。(もっとも、Entityとその階層を定義しているSchema.org は、Entityを英語の名前で定義しています。)

ただ、そうした理念に導かれたEntityモデルですが、現実的な問題がありました。それは、Entityの階層にしろ、それぞれのEntityの持つPropertyにしろ、それらは決してアプリオリに与えられるものではなく、それを人間が経験的に必要に応じて決めざるを得なかったことだと僕は考えています。

それは、「folksonomy (分類の仕方はみんなで決める)」というEntityモデル構築の実践的方法論の中核に関わる問題です。folksonomyという指針がなければ、Entityモデルは発展しなかったのは確かだと思いますが、それは、本来の「存在」を客観的に反映した意味の世界を網羅的につくるというより、直接的にはネット上の人間の活動の欲求を反映した、平凡で陳腐な分類作業が中心になっていったように思います。

Entityモデルの変化で、特徴的な出来事は、ある時点で Entityの一つとして、ActionというEntityが導入されたことです。Entityの世界は、静的な世界で動きがありません。例えて言えば「名詞」しかない言語の世界です。そうした言語で、世界の意味の記述は不十分にしかできないのは明らかです。

一方、当初のIntentモデルは、動的な、いわば「動詞」だけからなる、もっと言えば、「動詞の命令形」だけからなる世界でした。ただ、世界がどんなにダイナミックな運動の中にあるとしても、動詞だけの言語で、ましてや「命令」で世界を記述することはできません。

Intentモデルの最初の変化は、「スロット」の導入でした。それは、「動詞」の「目的語」として「名詞」の導入にあたるものです。Intentモデルの第二の変化は、「Intent Signature」の導入で、当初は「動作命令」の文字列ラベルに過ぎなかったIntentに、Entityモデルを援用しながら「文」の性格を与えるものです。

こうした単純なものから複雑なものへのIntentモデルの「進化」は、意味の把握を追求しようとして人工言語モドキの中でおきた「進化」なのですが、とても印象的なものでした。

そこでは、EntityモデルとIntentモデルは融合しています。ただ、その過程を複雑なEntityモデルが、単純なIntentモデルを吸収したと捉えることはできないと僕は考えています。

前回、Googleの検索が、ChatGPTに置き換わることは現状では難しいだろうとと述べたのですが、Google検索技術の支柱の一つであるEntityモデルが、後発のIntentモデルの進化系より、優れているようには思えません。Googleの検索技術の変化が求められているのは、確かなことだと思います。

そもそも、人力だけで、網羅的な知識のEntityモデルを作るのは可能とは思えません。

その点、GPT-3のような大規模言語モデルは、人間の言語活動が生み出した、大量の「構造化されていない(Entityなどには未だ分類されていない)」生のテキストを直接機械に与えます、奇妙なことに、機械はそこから「何か」を見つけ出します。(この「何か」が何であるのかを、あらかじめ予想することができないことが問題なのですが。)

ただ、ChatGPTとGPT-3は、違うシステムです。「人間のフィードバック」に基づくというGPT-3とは決定的に異なるChatGPTの独自のアプローチが、ある種の形を変えたfolksonomy の導入として、システム自体の陳腐化を引き起こすことを僕は心配しています。

そのあたりの問題は、セミナーの後半であらためて考えてみようと思います。

--------------------------------

「Entityモデルの

Folksonomyと

ChatGPT 」 を公開しました。

https://youtu.be/41K60t5ZKoU?list=PLQIrJ0f9gMcMl-rOnfK6S5EPXazITzFeK

資料pdf

https://drive.google.com/file/d/1XYk1EtWVCxJVhIXEvbMeIEGaVTyV9G8I/view?usp=sharing

blog:「EntityモデルのFolksonomyとChatGPT」

まとめページ

https://www.marulabo.net/docs/meaning/

https://www.marulabo.net/docs/meaning/

コメント

コメントを投稿